Sobre la histeria climática

Hace mucho que tenía ganas de resumir lo que he aprendido estos últimos años pero este es el primer paso de unas cuantas iteraciones más que me permitan entender esto con mayor profundidad

NOTA: Para defender una teoría, esta debe ser capaz de soportar todas las críticas. Para refutarla, basta con que una de las críticas sea válida. Pues bien, en este post, enumero las encontradas por Carlos Madrid y añado otras. Son muchas, es decir, hay motivos de sobra para dudar del cambio climático antropogénico.

Introducción

El tema del cambio climático empezó a llamarme la atención cuando comencé a trabajar en una empresa de meteorología con algunos climatólogos también y al preguntarle a uno, me dijo que no sabíamos nada del clima y que no tenía sentido tomar partido en una u otra dirección, que hacerlo era ser un fiel seguidor de una religión. Si te quieres ahorrar toda esta lectura, lo mejor que puedes hacer es quedarte con esa idea y parar de leer aquí.

Si quieres saber más, esta conversación me llamó poderosamente la atención porque fuera del círculo más climatológico no parecía existir duda alguna de que estábamos calentando el planeta pero en cambio, precisamente hablando con gente entendida, parecía haber exactamente lo contrario y abrazaban la duda con naturalidad.

Por cierto, una diminuta parte de este texto está basado en mi experiencia, en mi propio aprendizaje, mientras que la inmensa mayoría lo está sobre todo en el sensacional trabajo de Carlos Madrid que desmenuza de forma magistral el trabajo del IPCC en este vídeo de youtube.

En cierto modo podrías decir que este texto una transcripción simplificada de su video. Por lo tanto todos los errores y cagadas son exclusivamente míos porque intento estructurarlo todo de una forma más ´facilmente comprensible” para mí, así como poner sus palabras en las mías para que todo tenga sentido. Pero recuerda, el coco de Carlos es de otro planeta y este asunto es de una complejidad acojonante.

También disclaimer: estas cosas las escribo para mí, para mejorar mi comprensión, por lo que todas las críticas que me ayuden a refinar mi explicación (Deutsch), me estarán ayudando a comprenderlo mejor. Trataré de refinar la explicación en sucesivas entregas si veo que vuestras críticas son buenas y me hacen entenderlo mejor.

Mi resumen de su video por cierto es que a lo que llamamos “ciencia del cambio climático” no lo es, sino que es una multitud de ajustes estadísticos aplicados a datos que están construidos por modelos que a su vez están creados usando esos datos como calibración. Además existen multitud de incertidumbres sobre la calidad de esos datos (la detección del cambio climático), el valor explicativo de los modelos (la atribución de las causas del cc) y la calidad predictiva de estos modelos debido a varios factores que comentaremos y a la cuestión anterior de la falta de valor explicativo.

Estos permanentemente parcheados y tuneados modelos se convierten para el IPCC en una especie de fuente de la verdad con la que se contrastan los datos de temperatura, nivel del mar, o fenómenos extremos sin que exista relación alguna entre el funcionamiento del modelo y funcionamiento de la realidad.

Siguiendo con Deutsch: sino existen explicaciones de la realidad, no podemos asegurar que lo que ocurra con el modelo sea lo que ocurra en la realidad. Esta falta de conexión es crucial para entender por qué la mal llamada “ciencia del cambio climático” no es ciencia sino pura cocina estadística.

El cONseNSo

El principal argumento de los que defienden categóricamente que existe un cambio climático antropogénico (causado por el hombre) que en ocasiones se torna en catastrófico es que existe consenso a este respecto. Dos motivos parecen apuntar a que esto no es así.

El primero lo explica este estupendo hilo en twitter y el segundo (que en realidad viene a ser el mismo) es que los científicos del IPCC suponen un subconjunto de científicos que proponen al IPCC los Estados miembros, del total de científicos del clima posibles y, de estos, el IPCC escoge con cuáles se queda. Claro, si te dedicas a escoger exclusivamente de entre todos los científicos solo aquellos que tiendan a tener opiniones parecidas a las tuyas, está claro que entre esos y tu vais a tender a alcanzar un consenso espectacular!! Para más INRI, el IPCC filtra qué informes ven la luz y cuáles no, es decir, autocensura aquellos que no siguen cierta línea.

Pero no es el hecho de que no exista consenso lo que hace falso (o mejor dicho, lejos de la confirmación) el cambio climático antropogénico. El consenso es solo eso, consenso. Algo no se convierte en cierto porque exista consenso. Cuando Einstein presentó su teoría de la relatividad existía consenso en que lo que Einstein decía no tenía sentido. Luego el consenso fue que lo sabía todo y ahora hay teorías que parecen superar algunas de las de Einstein.

Como dice Deutsch, la ciencia va de crear conjeturas que se validen y tras ello crear explicaciones de cómo funciona la realidad que se puedan someter a la crítica para tras esto, crear nuevas explicaciones que mejoren las anteriores, que se vayan cada vez más acercando a la mejor explicación de la realidad. Es el proceso de conjetura, explicación, crítica, nueva mejor explicación la que nos permite saber cada vez más.

Si nuevamente te quieres ahorrar este largo texto, basta con que sepas que no tenemos explicación científica alguna de cómo funciona el clima, entre otras cosas, porque no podemos experimentar ni crear aparatos que nos permitan validar nuestras teorías, hipótesis y explicaciones, todo lo que podemos hacer es tratar de convertir nuestras conjeturas en código que se convierta en un modelo que simule la realidad.

Pero una simulación no es la realidad nunca y menos todavía si está basada en conjeturas que están muy lejos de estar validadas ni explicadas. En otras palabras, es como si mis conjeturas en esta newsletter yo crease un modelo con ellas y dijese que tienen valor predictivo. ¡Pues no! El IPCC ha creado conjeturas, las ha convertido en un modelo y no solo no lo ha sometido esto a la crítica sino que existen una enorme cantidad de incertidumbres sobre todo el proceso que me hacen pensar de plano que nada de lo que se dice del cambio climático es ciencia. Y por lo tanto me reitero en mi conclusión:

no tiene sentido tomar medidas de ningún tipo basándonos en este supuesto consenso científico, incluyendo la transición ecolojeta.

No tiene sentido empujar nada que no sea llevarnos a la riqueza, porque la pobreza mata muchísimo más que el clima.

Otra cosa que siempre me hizo dudar es que precisamente no estuviese bien visto… DUDAR. Es decir, si yo no sé sobre clima, pues tiene sentido decir que no sé si existe calentamiento global antropogénico pero es que cuando a alguien le decías que dudabas de ello, te miraban con cara que iba desde el odio, hasta la pena por considerarte medio imbécil y la consecuencia natural era llamarte NEGACIONISTA cuando lo único que estás haciendo es, insisto, dudar, no negar. Dudar != Negar

Lo voy a repetir para que se entienda: refutar con todo este documento (en realidad Carlos) lo que dice el IPCC no es negar la posibilidad de que exista un cambio climático antropogénico. Es tan solo decir que esto está MUY LEJOS de estar demostrado y de hecho es más, es imposible demostrarlo porque no se puede falsar nada que se diga sobre el clima al ser imposible hacer experimentos relacionados.

¿Existe calentamiento global (a secas)?

Empecemos por partes: en primer lugar, el calentamiento global (antropogénico o no) existe. Pero en casi toda la historia siempre vas a encontrar un período respecto al cual se esté produciendo un calentamiento en algún lugar en algún momento. Para comprobarlo tenemos la paleoclimatología que mencionaremos más adelante.

La cuestión es respecto a qué, a qué es debido y si esta detección y atribución nos permiten un poder explicativo que también nos permita predecir un calentamiento o enfriamiento global en el futuro basándonos en esto.

Para empezar, tenemos la distinción entre tiempo y clima. Tiempo es la situación meteorológica en un momento concreto en un lugar determinado y clima es la media habitual de situación meteorológica durante un período de tiempo. Arbitrariamente se decidió que ese período fuese de 30 años porque no existían más de 30 años de registros cuando se empezó a hablar de estas cosas en la década de los 50 del S. XX.

Pero 30 años es un suspiro en la historia del planeta, luego hablar de anomalías respecto al clima en períodos de tan solo 30 años es para empezar bastante absurdo. Por ejemplo a geólogos 50 años les parece lo mínimo necesario y en cambio a modelizadores que escriben ecuaciones y simulaciones con 20 años les basta.

Otra cuestión es que no existe la ciencia del clima sino que el clima es un sistema tan complejo que en el intervienen científicos de múltiples disciplinas, hasta economistas que meten modelos de crecimiento económico en las ecuaciones para predecir el clima a 100 años vista.

Desde las capas más altas de la atmósfera hasta las más profundas del mar tienen impacto en cómo se comporta el clima y no existe nadie que domine todo eso; necesariamente debe haber colaboración entre personas de distintas disciplinas.

Cuando hablamos de consenso sobre el cambio climático antropogénico (según IPCC), ¿de qué hablamos exactamente? De que:

Existe un calentamiento global de la tierra respecto a 1850-1900 (1.09ºC)

La causa dominante es el efecto invernadero provocado por emisiones de CO2 y otros gases de origen antrópico (humano).

Como consecuencia, ciertos fenómenos meteorológicos extremos son más frecuentes (olas de calor, sequías, lluvias torrenciales..) (esto punto sobre todo se dice en el 6º informe del IPCC de 2021 porque en el 5º de 2013 no se decía esto)

Nota sobre la afirmación estrella

Esta es la afirmación estrella del 6º informe del IPCC:

“Es más probable que no, que ningún periodo multisecular desde hace 125000 años haya sido mas caliente que la década reciente 2010-2020”

Es decir, más probable que no, es que la probabilidad de que sea falsa la afirmación anterior puede ser de hasta el 50%, un margen de error absolutamente acojonante. ¡¡Así también hago yo predicciones!!

Los registros paleoclimáticos parecen indicar que justo hace 125k años fue más caliente sin duda.

Esta forma de “hacer predicciones” parece estar relacionada con las furibundas críticas de naomi oreskes que venía a decir que los científicos no debían exigirse tanto como que fuesen capaz de afirmar cosas sin margen de error, que debían aplicar las mismas exigencias que cuando se declara culpable a un asesino cuando es superior al 50% de probabilidades.

Pero esto, ¡no es ciencia!

Esta es la gráfica de la que se extraen estas conclusiones:

El estancamiento de las temperaturas en el período 1940-1980 llevo a muchos a pensar que lo que se acercaba era una glaciación y pensaban que era por la carbonilla generada por el consumo de carbón que frenaría la radiación y con ello bajaría las temperaturas.

Desde 1980 a 2023 vemos un calentamiento global pero con una parada en el ascenso, la que se produjo en el período 1998-2010

Con esta gráfica empezaremos a hablar de tres problemas del cambio climático tal y como está planteado:

Detección: en base a qué datos se ha detectado este cambio climático

Atribución: Decir a qué causa corresponde

Predicción: Si lo anterior tiene poder explicativo (spoiler: no lo tiene), podemos crear modelos que nos permitan predecir el comportamiento en el futuro.

DETECCIÓN

En primer lugar, existe una suerte de circularidad, porque se utilizan modelos para tener un histórico de datos y se utilizan esos mismos datos para validar los modelos de predicción y ambos no están exentos de incertidumbre, luego la incertidumbre en unos alimenta todavía más incertidumbre en los segundos.

La temperatura global no es un dato bruto sino un estadístico

Para empezar a hablar de cómo obtener estos datos y estos modelos, debemos diferenciar entre lo que es la temperatura local y la temperatura global. La local se puede obtener en cualquier sitio con un termómetro.

La global es en cambio un estadístico

porque se hacen una serie de cálculos a series de datos de temperatura global en un número limitado de localizaciones para obtener una temperatura global. En otras palabras, no existe un termómetro global que podamos usar. Tomamos temperaturas con estaciones meteorológicas, globos sonda, boyas marinas, satélites, etc… y a partir de ellos se hace una especie de promedio estadístico.

El problema es cómo se hace ese promedio? Con la OMM se obtienen las temperaturas max y min del día y se divide entre dos, mientras que en países soviéticos se miden 4 temperaturas al día y se dividen entre cuatro. Luego ambas fuentes difícilmente se deberían comparar la una con la otra.

Existe además un problema de cantidad y calidad de los datos de partida porque no ha existido desde siempre una red espacial y temporalmente distribuida de observaciones. Los globos sonda por ejemplo solo se empezaron a usar desde 1950 y los satélites climáticos a partir de los 80.

Solo existen 200 estaciones meteorológicas en todo el mundo que contengan observaciones de temperatura que cubran todo el siglo XX y todas ellas están situadas en tierra y en Europa o Norteamérica y casi todas ellas en o cerca de ciudades, con lo cual hay que tener en cuenta el efecto isla de calor, que se suele corregir restando unas centésimas de grado en función de la población.

Esto requiere por lo tanto una cocina estadística muy importante y unos sesgos en los cálculos. Hay otros sesgos también que tienen que ver con los cambios en la instrumentación a lo largo del tiempo y con sus calibraciones, que han sido importantes(esto lo confirmo yo con mi experiencia meteorológica). Y otro más es que a veces la ubicación de las estaciones cambia.

En definitiva, no existe un dato bruto con el que se pueda trabajar sino que en todos los casos se emplean todo tipo de técnicas estadísticas para calcular medias, ajustarlos y homogeneizarlos y reanalizarlos.

Todo esto genera incertidumbres adicionales que se van a acumulando en los datos de partida que empleamos para la detección del cambio climático. Hacen de estos datos enormemente criticables (de hecho hacen EMO que no sean serios) en caso de ser empleados para inferir explicaciones de cómo se comporta el clima.

Esto ha provocado que por ejemplo la Nasa en 2011 dijese que 2009 había sido el año más cálido desde que existen registros y que en cambio un instituto inglés dijese que nanay y el motivo es que los métodos de cálculo de ambos fuesen diferentes.

Por lo tanto la cantidad de complejidades que existen solo en la detección es acojonante.

Guy Stewart Calendar en 1938 basándose en datos de 200 estaciones sostiene que los aumentos de CO2 son los que provocan los aumentos de temperatura. Sus teorías fueron recibidas con escepticismo entre otras cosas porque las estaciones estaban todas situadas todas por encima del paralelo 45º Norte

El primer IPCC tomaba en cuenta solo 1880 estaciones en su primer informe y el último (2021) 40k pero de esas, nuevamente, muy pocas cuentan con datos de todo el S. XX precisamente por ser mayoritariamente muy nuevas. En la gráfica anterior se puede ver como la inmensa mayoría del planeta no tiene datos y la inmensa mayoría de todos ellos están en el hemisferio norte.

Por lo tanto existe una clara incertidumbre respecto a los valores de las series instrumentales.

Otro asunto es que si estas incertidumbres existen respecto a las temperaturas, que son mucho más fáciles de medir, imaginémonos respecto a precipitaciones, nivel del mar o fenómenos extremos, que cuentan con series más cortas y de menor cantidad y calidad por contar entre otras cosas con sensores que generan muchos más problemas que un termómetro.

Entonces la pregunta que surge es si los aumentos de temperatura desde 1980 son extraordinarios y para eso hay que conocer los datos de temperatura del pasado y para ello tienen que recurrir a la paleoclimatología de la que no existen mediciones de termómetros.

Para ello recurren a datos indirectos o proxy:

Anillos de crecimiento de los árboles

Aire fósil atrapado en burbujas de testigos de hielo

Datación de sedimentos lacustres

Corales

Estos datos proxy se estudian de diferentes fuentes y como se correlacionan con la temperatura se puede predecir. El problema es que esta reconstrucción del pasado está sujeta TAMBIÉN a incertidumbres, como se explica con la controversia del palo de hockey

Para empezar, los árboles que se emplearon para analizar los anillos de crecimiento y con ello reconstruir esta gráfica, solo crecen en el hemisferio norte, lo cual es un problemón por sí solo.

Hubo muchas críticas a esta gráfica derivadas de la metodología empleada para calcular estos valores. Añadido a esto, llegó el climategate, un hackeo en 2009 a la universidad de east anglia en los que se obtuvieron múltiples correos incluidos de Michael Mann en los que parecía haber presiones para no mostrar datos que contradijesen ese palo de hockey (algo que en cualquier caso no parece infrecuente entre científicos que traten de impulsar determinadas conclusiones).

Tras las quejas por el climategate, hemos pasado del palo de hockey a lo que se llama el plato de espaguetis:

Plato en el que lo que tenemos es que hubo una pequeña edad de hielo en los S XVI-XIX y un calentamiento global en la edad media que iguala a las temperaturas de finales del S XX.

El ejemplo que siempre se pone de que ya no se discute esto, es que Greenland (groenlandia) significa tierra verde y es ese hecho de que fuese verde el que permitió a los vikingos en el medievo llegar hasta ella precisamente.

Si prestamos atención a lo que pasó antes del calentamiento medieval, vemos lo siguiente:

La parte alta de la gráfica de arriba es el óptimo climático del holoceno (8k ac hasta 4k ac) que en la gráfica de abajo se corresponde con el circulo rojo y desde entonces vivimos un importante enfriamiento que ha llegado hasta la pequeña edad de hielo de S. XVI hasta XIX.

Las temperaturas en ese óptimo climático del holoceno no eran tan altas como las actuales pero sí eran muy altas.

Y lo que podemos ver antes de eso es que han existido temperaturas más altas que las actuales, para empezar en el año 125k que es el que se decía en la afirmación estrella., pero bastantes más antes.

La paleoclimatología nos enseña que las temperaturas han sido más altas que en la actualidad en varias ocasiones y también que han fluctuado de manera igual o más acentuada incluso que en la actualidad. Sin perjuicio todo esto, sí que podemos decir que en los últimos 100k años, este calentamiento actual sí que es una novedad.

Pero claro, aquí estamos tratando de hacer una serie histórica usando datos de fuentes indirectas (mencionadas) y siguiendo con datos observados con todos los sesgos que ya hemos mencionado, luego las posibilidades de sesgo adicional son muy altas y por lo tanto las oscilaciones podrían haber sido mayores en alguna ocasión (aquí podemos citar que la granularidad de los datos que se obtienen con las burbujas de aire en hielo es de 300 años por ejemplo, luego no tenemos ni idea de lo que pasaba dentro de ese espacio de tiempo hace cientos de miles de años)

ATRIBUCIÓN

Hasta ahora hemos prestado atención a las fuentes de incertidumbre en lo que a la detección del cambio climático se refiere. Esto podría hacernos dudar de que la metodología con la que se anuncia a bombo y platillo el problema no es científica sino estadística, de hecho en ocasiones chapucera.

Ahora pasamos a las fuentes de incertidumbre en lo que a la atribución se refiere, que es bastante más grave.

Fue Fourier el que en 1824 dijo que algunos gases eran gases de efecto invernadero (GEI). En 1862 fue Tindall el que identificó dos de ellos, el CO2 y el vapor de agua. En 1892 Arrhenius identificó la importancia del CO2, sobre la temperatura en superficie. Finalmente es Calendar el que en 1938 plantea que con aumentos de CO2 aumenta la temperatura en superficie pero fue muy criticado por estar todas las estaciones por encima del paralelo 45 norte.

A partir del 1957 empiezan a medirse las concentraciones de CO2 en ppm.

En el momento de hacer el video, Carlos afirma que estábamos en las 416ppm.

En 1979 otro científico envía un informe a la academia de ciencias de los USA en el que dice que el aumento de concentraciones de co2 seguirá haciendo aumentar las temperaturas.

En 1988 otro interviene ante el senado de USA y allí alerta ya de que el calentamiento global es una realidad. (se sabe que por origen humano porque el CO2 resultante de la quema de combustibles fósiles tiene mayor abundancia de un isótopo de carbono). No cabe duda por lo tanto, de que una parte del aumento del CO2 tiene que ver con el aumento de la quema de combustibles fósiles.

Entonces ahora la cuestión es nuevamente de detección. Tenemos que fijarnos en la paleoclimatología del CO2 con datos proxy (indirectos) nuevamente para saber si estas concentraciones de CO2 actuales son anómalas o no.

(La mayor parte de gráficas vienen del IPCC, univ de san diego o instituto gis por cierto)

Lo que vemos en la gráfica es que las concentraciones de CO2 han sido superiores a las actuales en múltiples ocasiones. Una de ellas el eoceno que coincide con temperaturas superiores a las de la actualidad. En el plioceno medio las temperaturas eran más altas que en la actualidad pero concentraciones de co2 prácticamente iguales o incluso un poco menores.

En el eoceno se sabe que las concentraciones eran de hasta más de 1000ppm

Las concentraciones actuales se sabe que son superiores a las que se han dado en los últimos 800.000 años.

Ahora bien, el principal GEI es el vapor de agua y de este apenas se habla en el IPCC.

La dinámica del clima es de una complejidad extraordinaria, mucho más de lo que podría parecer cuando todo se resume en: aumento de co2 -> aumento de temperatura.

Lo interesante es que aunque si bien existe una clara correlación entre ambos, lo que ocurre en realidad es que es la temperatura la que sube y unos 500 años después es el CO2 el que lo hace.

La causalidad por lo tanto, si existe, sería a la inversa, sería el aumento de la temperatura el que provoca aumentos de concentración de CO2!!

Ya ni siquiera sostiene nadie por estos motivos que la explicación de las glaciaciones haya tenido que ver con el CO2 sino que ahora se sostiene que atienden a motivos astronómicos, relacionados con la posición del planeta, el ciclo solar, etc….

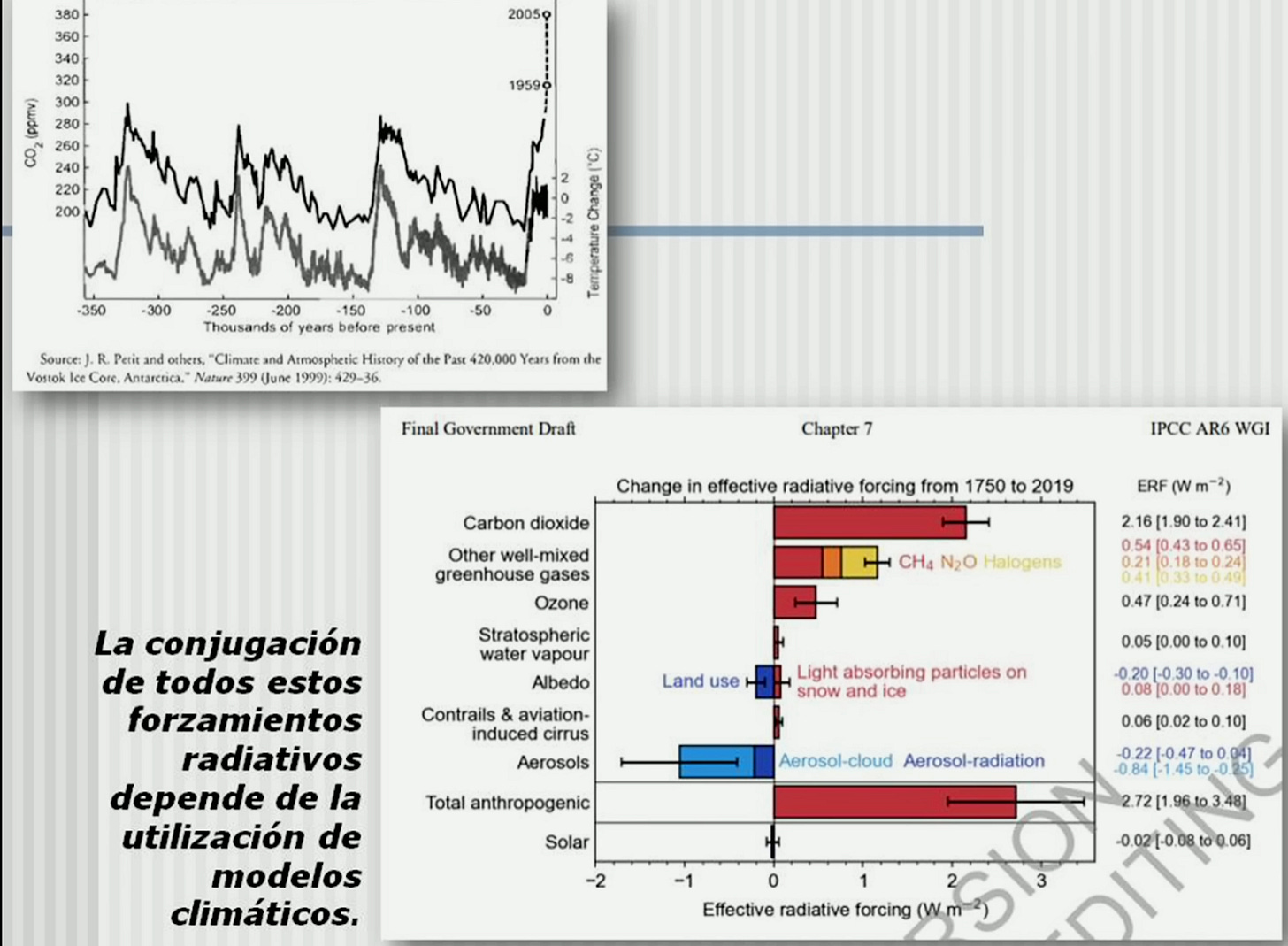

Otros posibles factores causales antrópicos (humanos) que se suelen tener en cuenta para el calentamiento global (que llama forzamientos):

La radiación solar (el IPCC no lo considera)

El uso del suelo humano

Factores naturales que tienden a enfriarlo (actividad volcánica, pinatubo por ejemplo, enfrió el planeta durante dos años)

La propia quema de combustibles podría hacer el aire más opaco y frenar la radiación

En la gráfica de abajo se puede observar como el margen de error de los aerosoles es el más alto (barritas) lo cual viene a decir que es el forzamiento sobre el clima del que menos sabemos. En el total se puede observar que el margen de error total que admite el propio IPCC es bastante alto.

Se podría dar la paradoja de que con la transición ecolojeta podríamos dejar de emitir la carbonilla que para la radiación y a su vez con el uso masivo del suelo que hacen estas tecnologías, podríamos hacer que la radiación se absorba más, ¡luego aumentando la temperatura del planeta!

Para evaluar toda esta gigantesca cantidad de factores es para lo que usa el IPCC los modelos climáticos. La atribución del cambio climático corresponde por completo a modelos climáticos, no existe un experimento que podamos hacer para comprobar o verificar que una explicación nos permita saber cómo funciona el clima.

Son modelos que intentan simular el comportamiento de todas las capas que hemos mencionado, atmósfera, litosfera, biosfera, añadiendo estos factores antrópicos (creados por el hombre) etc…

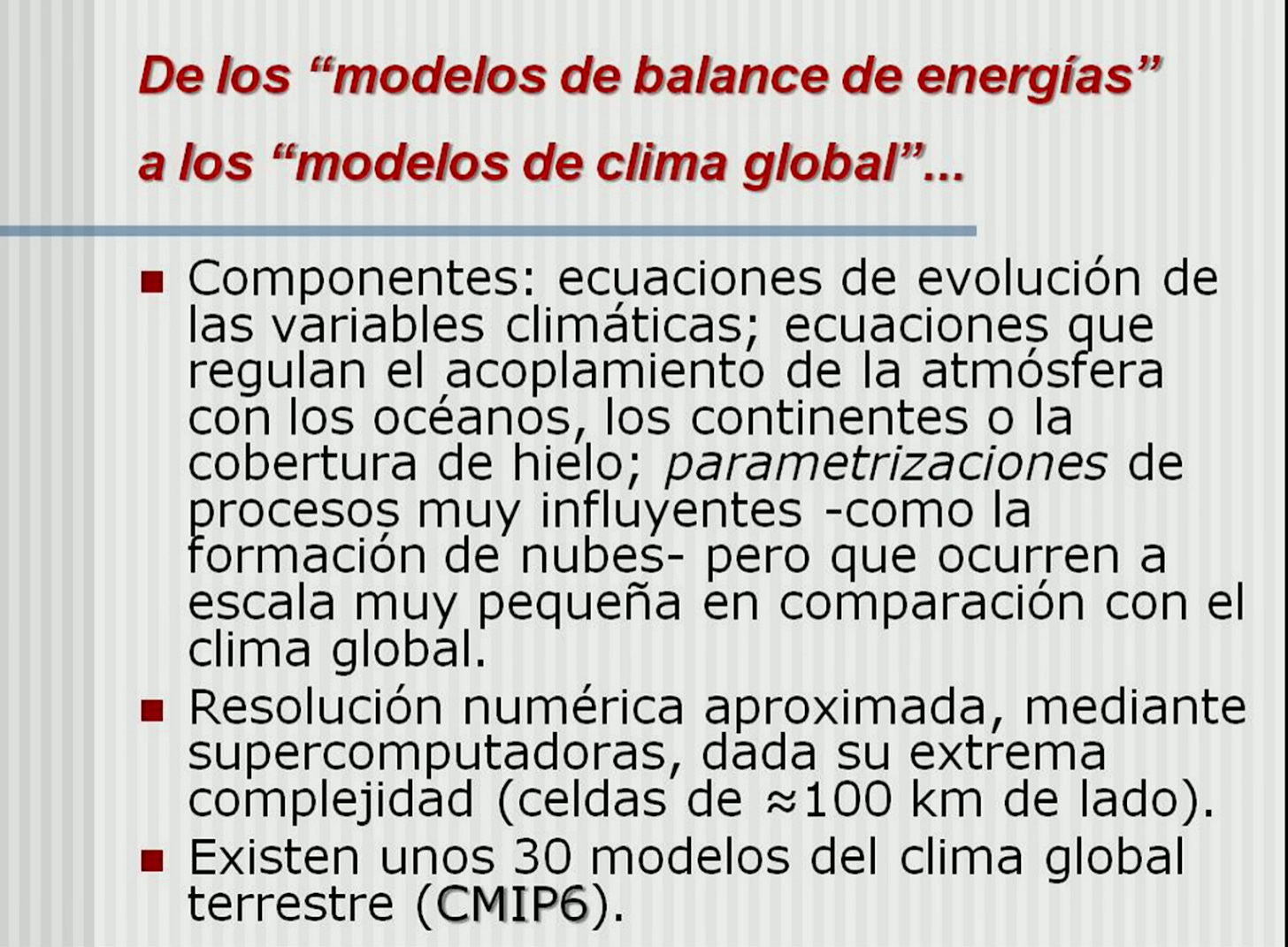

Los componentes de estos modelos:

Una primera cosa que podemos mencionar sobre estos componentes es el de las parametrizaciones, pues hay fenómenos que ocurren a una escala microscópica en relación con lo que es la totalidad del planeta (como la formación de nubes) y que no se meten en los modelos porque harían resolver las ecuaciones inviable incluso para supercomputadoras.

Entonces se meten parametrizaciones para compensar estos errores. Con ajustes y ponderaciones muy arbitrarias de esas parametrizaciones que ya explicaremos, tratan de simular esos fenómenos “microscópicos en relación con el clima global”

En segundo lugar, dado que son ecuaciones de extrema complejidad, requieren supercomputadoras y se divide el planeta en celdas iguales de 100km de lado aprox, luego se asume que todo lo que ocurre dentro de una celda sea igual. Las variaciones regionales por lo tanto no son recogidas en estos modelos.

Existen 30 modelos, que son pocos según Carlos (yo no tengo opinión a este respecto).

Entonces nos encontramos con que solo cuando los modelos se ejecutan actuando forzamientos naturales y antrópicos (ponderados de cierta manera) se reproduce el incremento de temperatura global.

El problema es que la evidencia estadística no implica inferencia causal.

Esta es la madre del cordero porque no existen mecanismos de interacción entre una y otras o no se conocen en absoluto. ¡¡Lo único que se ha hecho es ponderar esos forzamientos (es decir, según ellos causas del cc) hasta que la gráfica del modelo ha coincidido con las observaciones!!.

Vamos, a ver si lo explico, para los Bitcoiners es lo mismo que el modelo S2F que es una tomadura de pelo, porque a pasado tu siempre puedes hacer que un modelo se parezca a unas observaciones, pero eso tiene exactamente CERO valor predictivo, ya que estás encontrando una mera correlación pero sin relación causal entre una y otra (sin atribución).

Esto es de Deutsch: No existe una explicación de por qué en la gráfica 2 existe una identidad sintética entre el modelo ponderado en la cocina y las observaciones. De hecho la mejor prueba es que en los aerosoles exista un margen de error tan grande y reconocido y que aún así se esté metiendo en el modelo con naturalidad.

Por lo tanto la atribución causal está exclusivamente basada en métodos estadísticos.

Además, no podemos hacer experimentos para validar X teoría con el clima. Desbordan cualquier dispositivo experimental, por lo que solo nos podemos basar en estos modelos climáticos. Estamos por lo tanto ante una ciencia de simulaciones y ordenadores en vez de aparatos y experimentos.

PREDICCIÓN

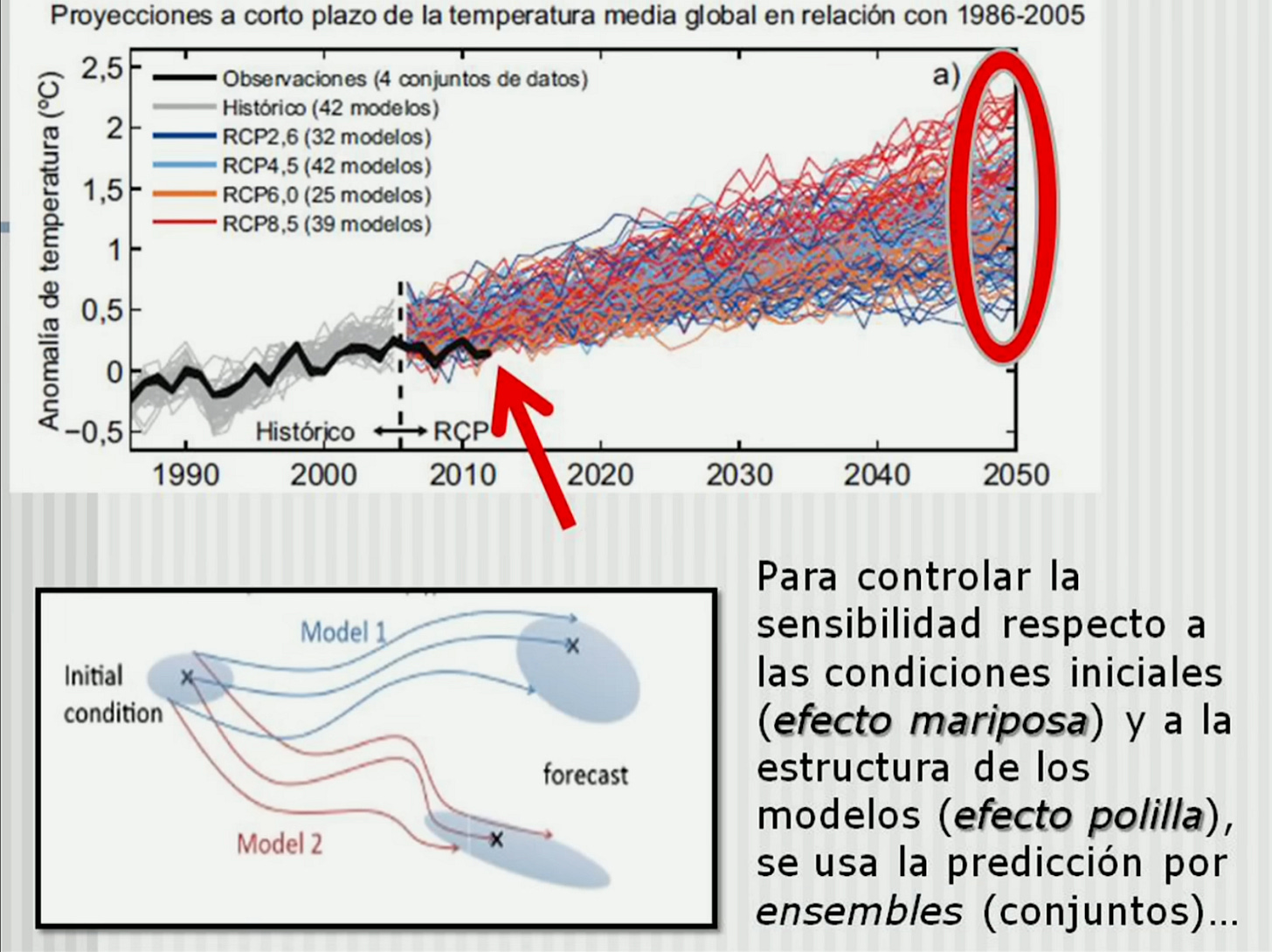

Y ahora pasamos a la predicción y aquí hablaremos del caos determinista. Una vez que estos modelos reproducen el aumento de temperatura global hasta el presente, estos mismos que ya he dicho que tienen CERO valor predictivo, se usan para predecirlo hasta el 2100

Esto además lo reconoce el IPCC, por lo que habla de que la predictibilidad es inherentemente limitada. Es decir, aún en el caso de que 1) la detección fuese buena y la 2) atribución también, tenemos un problema con 3) porque no podemos tener certeza exacta de conocer todos los datos necesarios para conocer el tiempo meteorológico en un momento determinado. Y el efecto mariposa nos dice que el caos del clima dará como resultado al cabo del tiempo salidas del modelo muy diferentes entre sí dependiendo de las condiciones iniciales. Sino podemos tener certeza de las condiciones iniciales en el momento exacto, significa que el resultado final puede ser exageradamente diferente al real.

El mejor ejemplo es de hecho el descargo de responsabilidad de la propia AEMET.

“No se comprende totalmente” ¡¡¡por lo que no asume responsabilidad por nada!!!

De hecho, se suele achacar a la variabilidad del clima ese estancamiento que se produjo en el aumento de temperaturas entre 1998 y 2012 que el modelo “predictivo” no fue capaz de ver.

Hizo falta muchísima cocina estadística para que finalmente las observaciones cayesen dentro del rango (más bajo) de todas las posibles salidas de los conjuntos de modelos como se puede ver aquí abajo:

Para controlar la sensibilidad de los modelos respecto al efecto mariposa y respecto al efecto polilla (diferentes modelos), usan la predicción por ensembles.

Estos los usábamos en la empresa en la que yo trabajaba para que se viesen tendencias. Hay caos respecto a múltiples factores y para eso tenemos los ensembles o conjuntos de condiciones iniciales (para contrarrestar el efecto mariposa) y conjuntos de modelos (para contrarrestar el efecto polilla)

Si los modelos coinciden mucho, significa que existe poca incertidumbre, si coinciden poco, mucha incertidumbre. Se dice que un resultado es robusto cuando al menos ⅔ de los modelos predicen ese resultado -> ojo! Esto no tiene nada que ver con que la predicción sea buena!!

Predicciones robustas: evolución temperatura aumento, precio globales, evolución del hielo ártico

No robustas: variaciones regionales de temp o precio, evol del hielo antártico, fenómenos extremos

El hielo se está deshelando en el ártico pero no hay una tendencia significativa en el hielo antártico y el 90% del hielo está en la antártida, hay regiones que sí y otras que no y los modelos no son capaces de reproducir.

El error más gordo de este modelo es que aunque la salida que se da sea robusta (27/30 modelos dan ese resultado), ¡¡no quiere decir que sea más probable!!

En primer lugar porque no es una muestra aleatoria simple de modelos, todos están escogidos por los cocineros de todo esto, y todos estos modelos están influenciando a los demás porque comparten módulos, los cientificos del clima suelen compartir código, luego es esperable que las formas de reproducir la realidad en unos se parezcan a otros. En los congresos suelen compartir cosas como: “oye, cómo has ajustado esto?, vale pues yo lo ajustaré así o haciendo esto otro”. Es decir, todos se influyen mutuamente y no tiene sentido pensar que es una muestra aleatoria. Sería como inferir un resultado electoral basándose en la encuesta a una familia que comparte educación, influencias, etc…

Ni los modelos ni las simulaciones entre sí son independientes.

El IPCC va haciendo hincapié en que los modelos van convergiendo lo cual tampoco es cierto pero es que no es lo más importante, sino que lo es la independencia de estos.

Lo que los científicos del clima dicen a esto es que trabajan con los mejores conjuntos (ensembles de oportunidad) que tienen, pero esto no es una explicación válida, porque puede ser la mejor explicación pero de un mal lote de modelos.

Otra cosa que se ve es que las estimaciones de la probabilidad muchas veces no son por métodos estadísticos cuantitativos sino cualitativos con los problemas que ello comporta, es decir, se reúnen para decidir por consenso si algo se considerará una buena predicción, mala o regulín, sin números detrás que lo soporten.

Por si fuera poco, ellos son conscientes, y por ese motivo la palabra predicción se ha eliminado, ahora con la neolengua hacen “proyecciones” en las que se incluyen simulaciones económicas al ser de gran impacto la evolución de la economía.

El cómo va a funcionar la temperatura en el futuro va a depender tb de la economía global, la tecnología, la población y con ello estiman las emisiones de GEI. Eso lo meten en el modelo y se añaden incertidumbres adicionales (como si hubiese pocas)

Las salidas optimistas (en términos de emisión de CO2) (las dos menores en el gráfico de la derecha) son muy poco realistas, porque suponen entre 2015 y 2100 es que apenas suben las GEI. Con las salidas pesimistas la idiotez es que si vamos hacia una catástrofe, en algún momento deberíamos llegar a un punto de no retorno que destrozará la economía y que hará que no se emita ni un gramo de CO2, es decir, debería haber una caída monumental. Sin embargo las más pesimistas plantean que las emisiones GEI suben y suben y solo bajan un pelín al final en el más pesimista (gráfica abajo derecha).

En otras palabras, el propio IPCC, en su escenario de economía más robusta y generando más CO2, no plantea una catástrofe de tal magnitud que pudiese llevar a la economía a un escenario tan apocalíptico en el que se dejen de generar emisiones de CO2. Es decir, la economía en ese escenario tan HORRIBLE iría tan de puta madre, que se seguirían generando CO2 como si no hubiese un mañana. Es decir, es hilarante lo absurdo que resulta este escenario.

Es añadir más y más incertidumbres el juntar modelos de economistas con los de físicos, es un mejunje totalmente imposible.

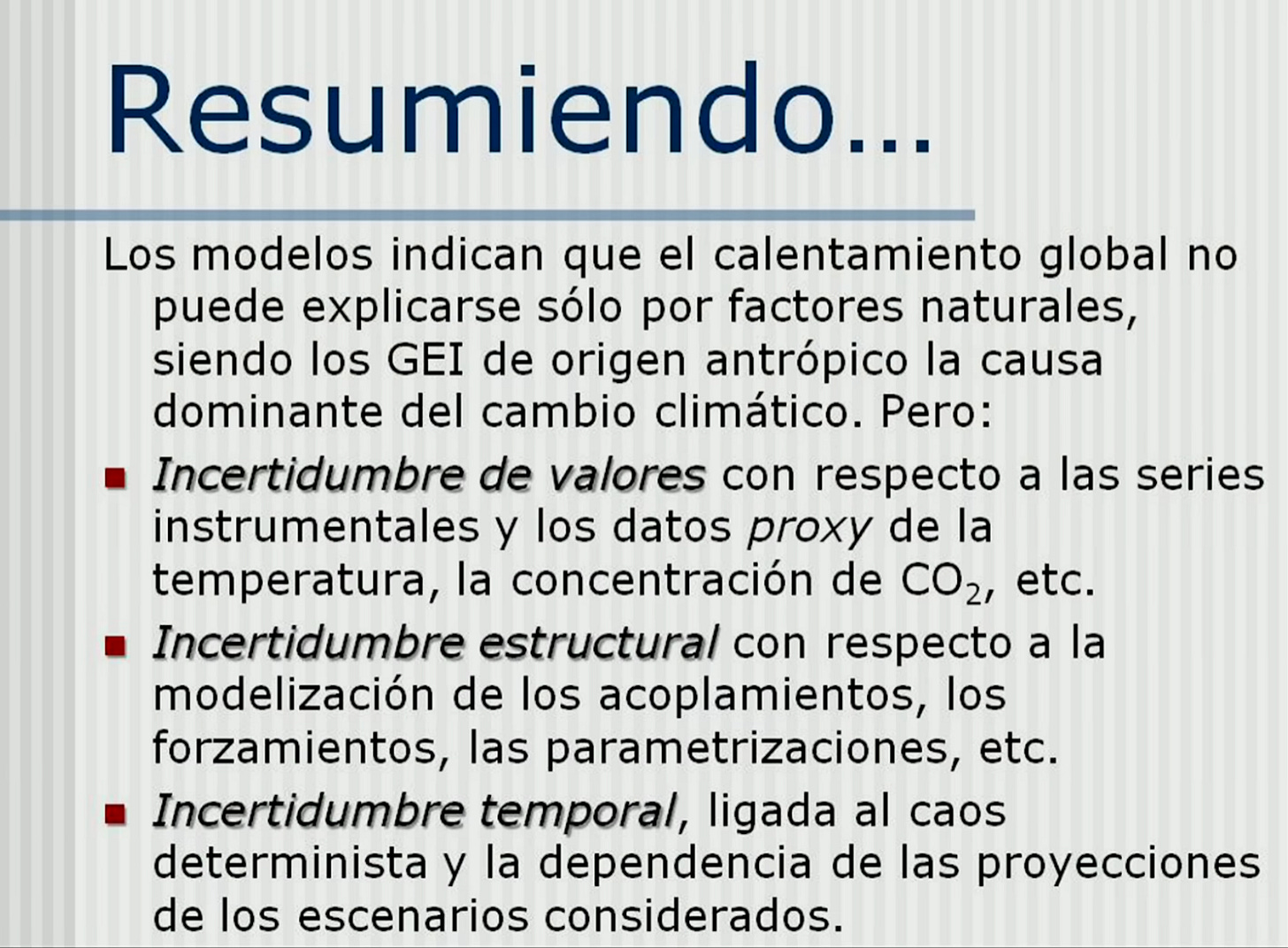

RESUMEN:

Podría ocurrir que en la gráfica de que el teorema fundamental de la identidad sintética, usan los datos de observaciones tanto para validar el modelo como para calibrarlo. Claro, así cualquier modelo es cojonudo.

La calibración podría entonces estar enmascarando la calidad del modelo en el pasado y en el presente. No hay garantías por lo tanto de que los modelos puedan funcionar a 50 o 100 años.

Se parchean los modelos una y otra vez para que recojan las observaciones más recalcitrantes.

El IPCC en el último informe admite ahora que los modelos ya NO son representativos del clima pero que son adecuados para ciertos propósitos, modelos que antes te pedían que tomaras como CIENCIA y que la mayoría del pueblo llano sigue llamando CIENCIA.

Pero no, señor, eso no es ciencia porque aunque ignorásemos los enormes fallos en las series de datos (detección), nada de lo que está introducido en los modelos tiene valor explicativo (atribución) ni predictivo. (predicción)

Muy buen resumen.

El problema es que argumentar todo esto ante los que te llaman negacionista por dudar, es algo imposible.

A mí me gusta plantear la situación desde otra perspectiva:

Supongamos que el IPCC tiene razón, y así los que acusan de negacionismo por dudar todavía no pueden decir nada.

Las consecuencias catastróficas que nos venden son las que corresponden al escenario peor y a la vez menos probable de acuerdo con el propio IPCC. (Al decir esto además se evidencia al que sabe de lo que habla y el que habla de oídas).

Por tanto, según el propio IPCC, las consecuencias no son las que nos están vendiendo los medios.

Adicionalmente, el aumento de eventos naturales meteorológicos de carácter extremo o de "desastre natural" no está demostrado que se haya producido. No lo descartemos para que no nos acusen de nada, pero ahora mismo, no está demostrado.

Firmado:

Hombre Décimo (https://enlacea.com/hd1)

Tras leerte, pues he buscado el hueco para ver la conferencia que mencionas de Carlos Madrid, y lo primero a decir es que me encantó ver el disclaimer de la Aemet.

Está muy bien que hablen los profesionales del pensar, y que nos llegue lo que dicen.

Porque los amateurs nos encontramos huérfanos a veces, especialmente cuando nos encontramos cosas como ésta:

https://es.euronews.com/green/2019/12/11/distinguir-entre-emisiones-de-co2-naturales-y-humanas-es-vital-para-frenar-el-calentamient

En la que textualmente se dice “ningún sistema actual es capaz de diferenciar entre fuentes humanas y naturales de CO2”, dice Guido Levrini, director de la sección espacial del programa Copérnico de la Agencia Espacial Europea.

Y entonces, claro, ves rechazado tu argumento porque te dicen que esa no es una fuente fiable, que no son “los científicos”. Y alucinas. Porque lo único que sucede, es que es efectivamente el rey desnudo. Es decir, la realidad estropeando un buen titular.

O esta otra, que mencionaba al volcán de Tonga como gran disruptor climático, posible detonante de las altas temperaturas recientes.

https://www.elconfidencial.com/tecnologia/ciencia/2023-07-27/misterio-record-temperaturas-atlantico_3708643/

Y ya los comentarios finales de la charla, negando la categoría de ciencia, a la “ciencia” del cambio climático, me parece genial. A pesar de reconocer ellos mismos la dificultad de defender el argumento delante de climatólogos…

Por otra parte, y para finalizar, tengo que ver si has escrito algo sobre las nucleares en España, o si lo ha tratado Carlos Madrid, porque las menciona de pasada y es un tema recurrente últimamente, en que se menciona mucho la mina de Retortillo en Salamanca, y se publicita en prensa con muchas falacias respecto a los datos del Consejo de seguridad nuclear e incluso la Organización internacional de la energía, como costes y autonomía de recursos. Y es que en realidad estoy convencido de que todo el interés se centra en la instalación de la fábrica de enriquecimiento de Uranio, cuya autorización excede por mucho las competencias del ayuntamiento, e incluso, del país.

En cualquier caso, gracias Adolfo por promover el debate informado!

Un saludo